AI jako doradca wyborczy? Chatboty mylą partie

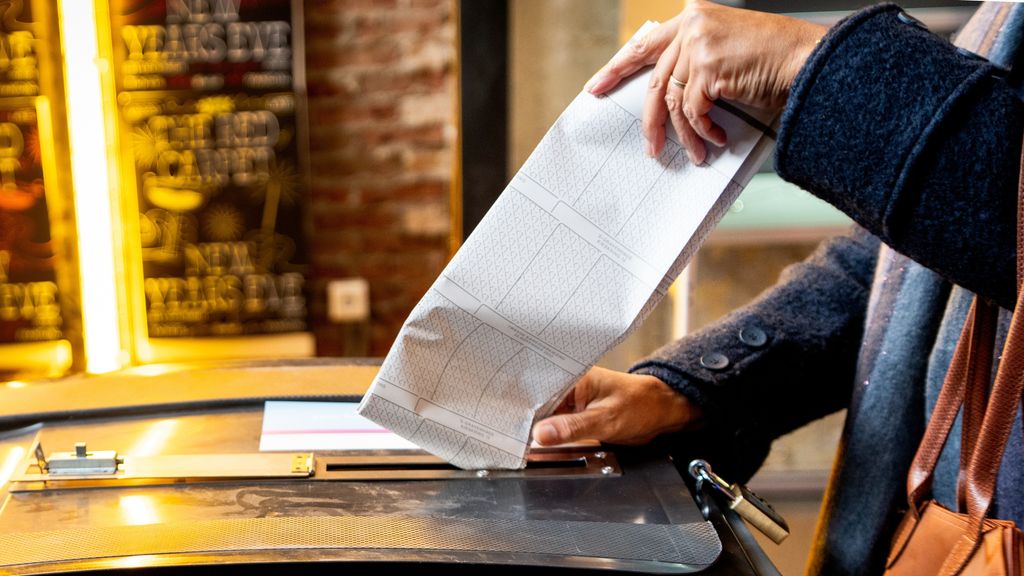

W obliczu nadchodzących wyborów do Tweede Kamer, AI-chatboty stają się coraz bardziej popularne. Czy można im zaufać?

AI jako doradca wyborczy? Chatbot myli VVD z PVV

„To dość zabawne”, skomentował polityczny komentator Ron Fresen w poniedziałkowym programie Eva Jinek. Komentator polityczny pozwolił AI-chatbotowi ChatGPT "opowiedzieć" o różnicach między programem wyborczym PvdA z 2012 roku a obecnym programem PvdA-GroenLinks. „To nieprawda, że partia stała się znacznie bardziej lewicowa. Zbliżyli się do centrum.”

Nie jest to dziwne, by zadawać chatbotowi AI pytania polityczne. Tego rodzaju narzędzie może błyskawicznie przetwarzać ogromne ilości informacji. Samodzielnie zajęlibyśmy się tym przez godziny, a nawet dłużej.

Ale czy to jest mądre, to już inna sprawa. W tym tygodniu okazało się, że nawet NotebookLM firmy Google myli programy partii.

AI-chatboty mogą być kuszącym doradcą wyborczym dla wyborców przed wyborami do Tweede Kamer pod koniec października. Jednak należy być ostrożnym.

„W dużych modelach językowych, takich jak ChatGPT, znajduje się wiele szumów”, mówi Claes de Vreese, profesor sztucznej inteligencji i społeczeństwa na Uniwersytecie w Amsterdamie. „Otrzymujesz odpowiedzi, w które wpleciono różne opinie. Odpowiedzi są zanieczyszczone.”

Nie wiesz dokładnie, jak chatbot dochodzi do swoich odpowiedzi. Prawdopodobnie ChatGPT, po zapytaniu Rona Fresena, nie tylko porównywał dwa programy partyjne. Najprawdopodobniej oparł swoją odpowiedź na ludzkich analizach z innych źródeł, takich jak Volkskrant czy Telegraaf.

PVV czy VVD?

Istnieją również chatboty, które twierdzą, że są całkowicie odizolowane od informacji zewnętrznych. Ale nawet wtedy mogą wystąpić błędy, jak pokazuje test Nieuwsuur narzędzia AI NotebookLM firmy Google. To narzędzie twierdzi, że porównuje tylko programy wyborcze i nie korzysta z informacji zewnętrznych.

Powinno to minimalizować ryzyko błędów. Mimo to narzędzie pomyliło VVD z PVV, gdy Nieuwsuur zapytał, co różne partie mówią o przyjęciu Ukraińców w Holandii.

„VVD proponuje odesłanie ukraińskich mężczyzn do Ukrainy”, podał NotebookLM jako odpowiedź. Zdanie to jednak pochodzi z programu PVV.

„Jeśli to się zdarza, jest to niepokojące”, mówi De Vreese. Rzecznik Google, Rachid Finge, przyznał błąd i powiedział, że zespół zajmujący się NotebookLM sprawdzi, „czy to jest halucynacja, czy dzieje się coś innego”.

Wzorce językowe, nie fakty

„Halucynacja” to termin często używany do opisywania błędów w odpowiedziach AI-chatbotów. W rzeczywistości chatboty halucynują cały czas. To modele językowe, które nie „rozumieją” świata, ale zostały wytrenowane na ogromnych ilościach tekstu, z którego uczą się wzorców językowych. Modele te przewidują następne słowo, które jest najbardziej prawdopodobne, niekoniecznie najbardziej prawdziwe.

Tak więc odpowiedzi mogą nie mieć nic wspólnego z rzeczywistością. Im lepsze stają się modele językowe, tym bardziej przekonujące są odpowiedzi i tym trudniej zauważyć błędy.

De Vreese mówi: „Kluczowe jest to, że nie wiemy, jak działa AI. Dlatego przynajmniej chcielibyśmy mieć wgląd w to, jak model działa.”

„Używaj ich tylko jako dodatkowego źródła”

Nie pytaj więc AI-chatbotów o polityczne porady wyborcze, radzi organizacja informacyjna Prodemos, twórca StemWijzer. „Bardzo trudno jest ocenić, jak wiarygodne i neutralne są odpowiedzi oraz na jakich danych są one trenowane”, powiedział rzecznik Gijs Boerwinkel niedawno w De Nieuws BV. „Informacje często są przestarzałe, podczas gdy chcesz otrzymać porady wyborcze oparte na najnowszych danych.”

De Vreese uważa, że chatboty są dobrym, uzupełniającym narzędziem dla osób, które nie chcą czytać wszystkich programów wyborczych. „Ale używaj ich tylko jako dodatkowego źródła informacji i rozrywki, a nie jako najlepszego doradcy w zakresie polityki. Staraj się zawsze oceniać odpowiedzi w kontekście tego, co już wiesz.”

Postuluje również wprowadzenie surowszych regulacji dotyczących programów AI. „Można wprowadzić zasady, które uniemożliwią udzielanie ostatecznych porad w kwestiach politycznych.”

„Początkowo firmy AI mówiły: zapewnimy, że nie będziesz mógł używać nas do doradztwa wyborczego. To jest już przeszłość, ale uważam, że zbyt szybko opuściliśmy ten etap. Teraz mówią: powodzenia, indywidualny obywatelu, w radzeniu sobie z tym. Z odrobiną pecha może pojawić się niekontrolowany dodatkowy wpływ na nasze decyzje wyborcze.”